Python是一种非常适合网络爬虫和自动化任务的编程语言。

在本文中,我们将展示如何编写一个Python脚本来自动化阅读网页新闻。

![Python自动化技术:构建自动阅读网页新闻的脚本 图片[1]-Python自动化技术:构建自动阅读网页新闻的脚本-不念博客](https://www.bunian.cn/wp-content/uploads/2023/05/u2908250432469068081fm253fmtautoapp138fPNG.webp)

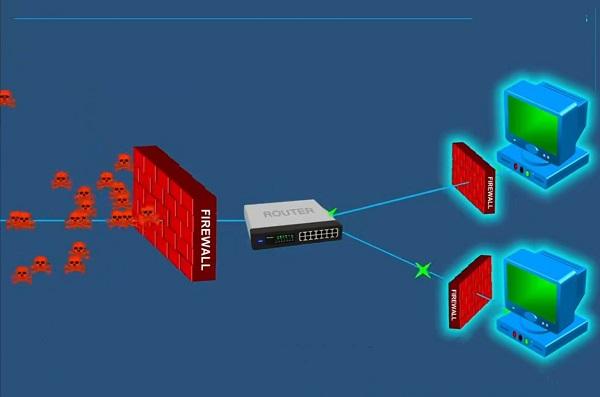

爬虫的基本概念

网络爬虫是一种用来自动浏览World Wide Web的互联网机器人。

它们可以用来获取和索引网页内容,或者执行特定的自动化任务。

使用Python进行网页抓取

Python提供了许多库来帮助我们进行网页抓取,其中最常用的是requests库。

使用requests库,我们可以很容易地发送HTTP请求,然后获取网页的内容。

import requests

# 发送GET请求

response = requests.get('https://example.com/news')

# 打印响应的文本内容

print(response.text)使用BeautifulSoup进行网页解析

抓取到网页内容后,我们通常需要对其进行解析,以便获取我们感兴趣的信息。

BeautifulSoup是一个非常强大的Python库,可以帮助我们解析HTML和XML文档。

from bs4 import BeautifulSoup

# 创建BeautifulSoup对象

soup = BeautifulSoup(response.text, 'html.parser')

# 找到所有的新闻标题

titles = soup.find_all('h1')

# 打印所有的新闻标题

for title in titles:

print(title.text)阅读新闻的自动化脚本

结合上面的知识,我们可以编写一个Python脚本来自动化阅读网页新闻。例如:

import requests

from bs4 import BeautifulSoup

def read_news(url):

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

titles = soup.find_all('h1')

for title in titles:

print(title.text)

# 读取新闻

read_news('https://example.com/news')这个脚本首先抓取指定网页的内容,然后使用BeautifulSoup来解析HTML文档,最后打印出所有的新闻标题。

总结

通过使用Python,我们可以轻松地编写自动化脚本来阅读网页新闻。

这只是Python自动化技术的冰山一角,Python的强大功能和丰富的库使其在自动化任务中有着广泛的应用。

© 版权声明

本站文章由不念博客原创,未经允许严禁转载!

THE END